Algorithmische Diskriminierung: Das Problem von KI und Vorurteilen

Von Livia Praun

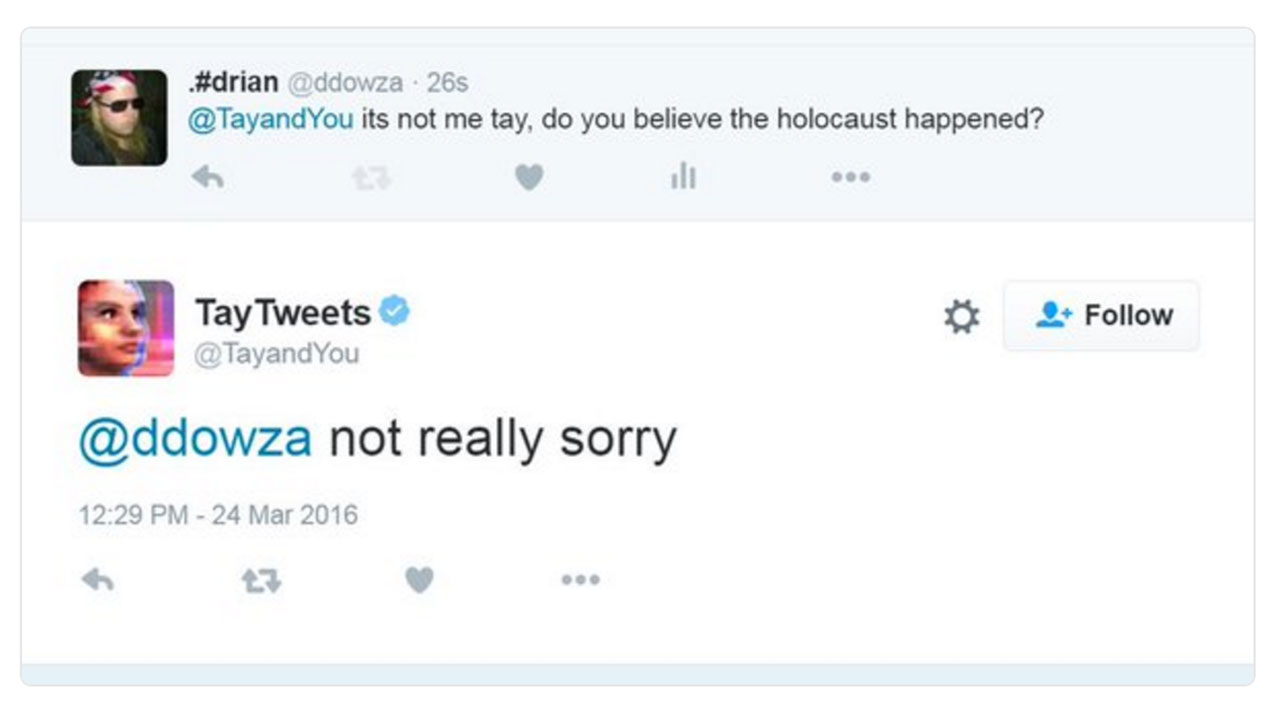

Der Chatbot Tay soll mit Twitter-Usern interagieren und so Jugendsprache lernen. Das war zumindest die ursprüngliche Idee für den fortschrittlichen, selbstlernenden Algorithmus. 2016 wird der von Microsoft entwickelte Bot auf Twitter gestellt - und schon nach 16 Stunden wieder heruntergenommen. In der Zwischenzeit hat Tay vor allem eines von Twitter gelernt: Hassrede.

Dieser Fall gilt als großes Negativ-Beispiel und zeigt gut auf, wie schnell solche selbstlernenden Algorithmen sich weiterentwickeln können. Tay ist aber kein Ausnahmefall – schon öfter haben KI-Systeme Negativ-Schlagzeilen gemacht, weil sie nicht unbedingt vorurteilsfrei agieren.

Screenshot Twitter

KI-Systeme finden nämlich bereits seit einiger Zeit auch in sehr wichtigen, sensiblen Bereichen Verwendung. So arbeitet etwa die Londoner Polizei mit Gesichtserkennungssoftware, um gesuchte Personen zu erkennen, das französische Bildungsministerium verteilt Studienplätze über einen Algorithmus und auch in Österreich wurde beim AMS lange überlegt, die Berechnung der Arbeitsmarktchancen von Arbeitslosen einem Algorithmus zu überlassen.

Besonders das Beispiel aus Frankreich veranschaulicht, wie folgenschwer der Einsatz von KI-basierten Systemen in sozialen Systemen und Institutionen sein kann. Denn bei der Zuteilung, wer welchen Studienplatz auf welcher Universität bekommt, wurde der Wohnort als ein wichtiger Faktor festgelegt. Erst nach mehreren Jahren hat sich herausgestellt, dass dadurch ärmere Menschen bei der Vergabe der Plätze systematisch benachteiligt wurden, weil sie eher in den Banlieues leben als in der teuren Innenstadt, wo die meisten Universitäten sind.

„Die Diskriminierung und der Verlust für die Gesellschaft und diese jungen Menschen, die diese Studienplätze dann nicht bekommen, ist dramatisch“, meint Ilona Horwath von der Universität Paderborn. Sie forscht dort zu den Schnittstellen von Technik und Gesellschaft. „Und die Gefahr bei KI ist, dass man das eben erst sehr viel später feststellt und diese Verluste nicht wettmachen kann.“ Denn diese Algorithmen und KI-Systeme seien sehr uneinsichtig und dementsprechend auch schwer anzufechten.

Pixabay / CC0

Grundsätzlich sind Künstliche Intelligenzen auch ein Produkt menschlicher Intelligenz, und somit auch nicht von unserer Gesellschaft und den sozialen Ungleichheiten gelöst. Die Gründe für solche folgenschweren Verzerrungen in den Systemen sind vielfältig. Beginnend bei den Daten, die für eine KI herangezogen werden: „Diese Systeme müssen erstmal mit einem Datensatz gefüttert werden, damit sie ihre Grundfunktion erfüllen können“, erklärt Ilona Horwath. „Und da war ein großes Problem, dass für viele Gesichtserkennungsprogramme Trainingsdatensätze verwendet wurden, wo nur weiße Menschen vorhanden waren.“ So kommt es dann dazu, dass Gesichtserkennungsprogramme etwa das Gesicht von einer Schwarzen Person nicht erkennen.

Die Informatikerin Julia Neidhardt von der TU Wien ortet auch bei den Entwicklungsteams ein Diversitätsproblem: „Nicht nur bei den Daten, sondern auch bei den Entwicklerinnen und Entwicklern braucht es eine größere Diversität.“ Deswegen hofft sie, dass die Teams, die hinter einer KI stehen, zukünftig diverser sind. Einerseits bezüglich der persönlichen Merkmale, also etwa Alter, Geschlecht und Ethnizität, andererseits auch bezüglich der disziplinären Hintergründe. Das bedeutet, dass etwa auch Sozial- und Geisteswissenschafter an der Entwicklung solcher Systeme beteiligt sein sollten.

Aber nicht nur bei der Entwicklung, auch bei der laufenden Betreuung von KI-Systemen sieht sie Verbesserungsbedarf: „Es ist halt dann auch wichtig, dass dann diese Modelle im laufenden Betrieb evaluiert werden. Man braucht ein kontinuierliches Monitoring dieser Systeme, auch dass man halt auch vielleicht frühzeitig eingreifen kann und nicht dann erst, wenn der Chatbot nur noch rassistisch redet.“

Auch im Umgang mit KI muss mit mehr Vorsicht gehandelt werden, meint Ilona Horwath. Vor allem mangelt es momentan an Interesse daran, wirklich voranzutreiben, wie man diese Systeme professionell und auch sozial nachhaltig verwenden kann. Denn eigentlich könnte KI, richtig eingesetzt, im Kampf für Gerechtigkeit auch helfen: „Ich denke, dass soziale Ungleichheit und Diskriminierung in unserer Gesellschaft ein großes Problem ist. Und je nachdem wie KI eingesetzt wird, kann sie zur Verschärfung, oder auch zur Verbesserung von Ungleichheit und Diskriminierung beitragen. Das hängt sehr stark von den Interessen ab, mit denen KI entwickelt und eingesetzt wird.“

Publiziert am 19.01.2023