Doku „Coded Bias“ zeigt wie diskriminierend künstliche Intelligenz sein kann

Von Philipp Emberger

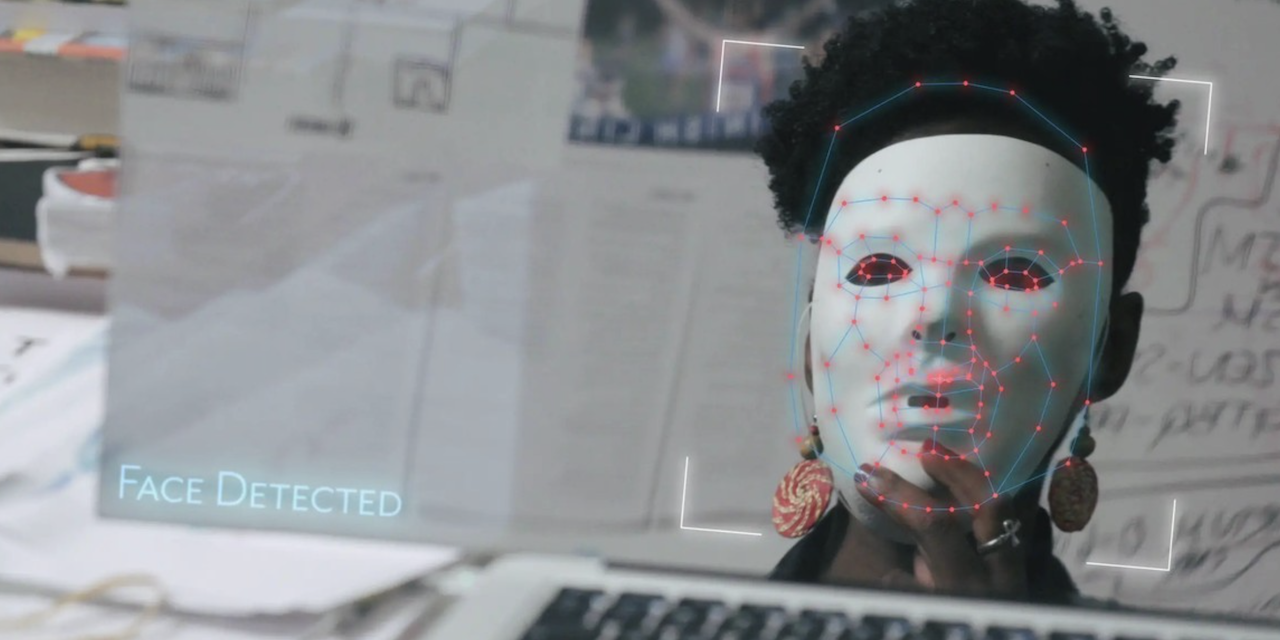

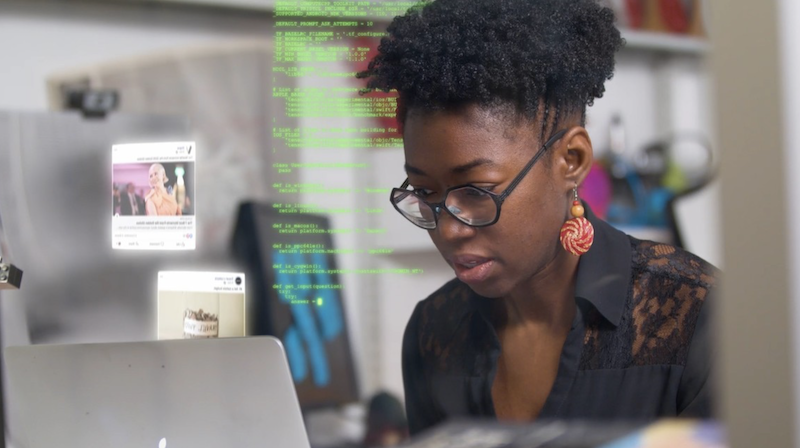

Eine Art Snapchat-Filter für einen Spiegel. Das ist der Ausgangspunkt des Dokumentarfilms „Coded Bias“ (deutsch: „Vorprogrammierte Diskriminierung“). Programmiert hat ihn die Computerwissenschaftlerin mit Wakanda-Ohrringen Joy Buolamwini, tätig am MIT Media Lab. Ihr Ziel war, dass ihr das eigene Spiegelbild jeden Morgen eine Freude bereiten soll. Nur: Die Software hat ihr Gesicht nicht erkannt, denn Joy Buloamwini ist eine Women of Colour. So hat sie rausgefunden, dass Gesichtserkennungssoftwares auf Gesichter von Weißen Menschen ausgelegt sind. Erst als sich Buolamwini eine weiße Maske aufgesetzt hat, wurde ihr Gesicht erkannt.

Die Wissenschaftlerin sah sich die hinterlegten Beispielgesichter in der Datenbank an und erkannte, dass fast ausschließlich Weiße Männer als Referenzen für die Software hinterlegt sind. Menschen mit einer anderen ethnischen Zugehörigkeit werden somit schlicht nicht erkannt. Es war der Auslöser dafür, dass sich Buolamwini mit Vorurteilen und diskriminierenden Verhalten von Computertechnologie auseinandersetze.

„Coded Bias“ von Regisseurin Shalini Kantayya versucht die Gründe sowie Auswirkungen des diskriminierenden Verhaltens von künstlicher Intelligenz zu erklären und aus verschiedenen Blickwinkeln zu beleuchten. Thematisch beschäftigt sich der Dokumentarfilm überwiegend mit den großen Themenbereichen von „Gesichtserkennungssoftwares“ und „Algorithmen“. Inhaltlich konzentriert sich Regisseurin Kantayya dabei vor allem auf die Gefahren, die mit diesen Technologien einhergehen, lässt aber an manchen Stellen Details und Kontext vermissen.

Netflix

Die Wissenschaftlerin Joy Buolamwini beschäftigt sich mit diskriminierenden Verhalten in Computertechnologien

Frage der Macht

Ein großer angesprochener Kritikpunkt ist, dass einerseits diese Technologien noch nicht ausreichend gut funktionieren, um beispielsweise für polizeiliche Zwecke eingesetzt werden zu können. Andererseits gibt es, selbst, wenn sie funktionieren würden, für die Einführung keine oder nur dürftige Rechtsgrundlagen. Der größte und sehr generalisierende Kritikpunkt ist aber, dass diese Technologien zu einem überwiegenden Großteil von einer Gruppe privilegierter Personen entwickelt werden und diese ihre eigenen Vorurteile auf die Technologien übertragen. Das Ergebnis ist, dass bisher bereits diskriminierte Personengruppen noch weiter diskriminiert werden und beispielsweise von Algorithmen bei heiklen Fragen wie nach der Krankenversicherung benachteiligt werden.

Netflix

„Es geht auch um mächtige Menschen, die machtlose Menschen klassifizieren“, heißt es an einer Stelle in der rund eineinhalbstündigen Dokumentation. Eine Sorge die Cathy O’Neil, Autorin des Buchs „Weapons of Math Destruction“, teilt. Ihre größte Sorge ist es, dass Algorithmen zu einflussreich und zu mächtig werden.

Problematische Beispiele en masse

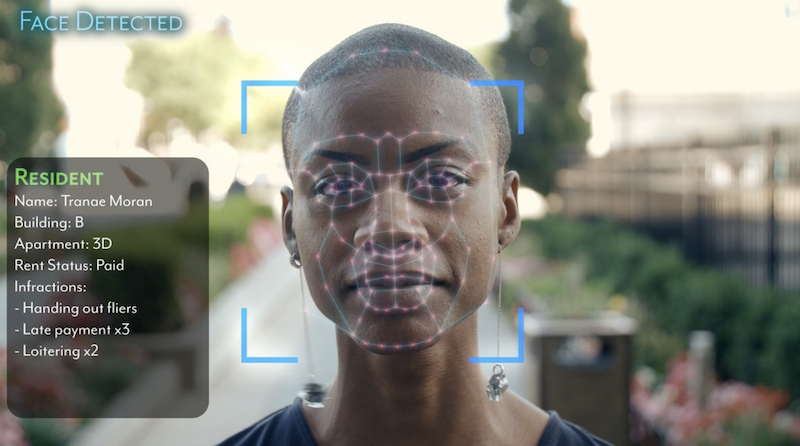

Die Doku liefert zahlreiche problematische Beispiele, darunter etwa ein auf Künstliche Intelligenz beruhendes Rekrutierungstool von Amazon, das alle Bewerbungen von Frauen auf eine Jobausschreibung aussortierte. Ein weiteres Beispiel ist eine Vermietergesellschaft aus Brooklyn, die ihre Mieter*innen mit Kameras überwacht und auf Fehlverhalten aufmerksam macht.

Netflix

Die Beispiele und die Sicht in der Dokumentation sind auf den englischsprachigen Raum zugeschnitten. Österreich ist in diesem Zusammenhang aber keineswegs ein sicherer Hafen. Das Arbeitsmarktservice arbeitet mit einem „AMS-Algorithmus“, der Arbeitslose automatisch in verschiedene Kategorien einteilt und darüber entscheiden soll, welche Leistungen diese bekommen sollen. Nicht unproblematisch wie hier und auch hier nachzulesen ist.

Auch für das Thema der Gesichtserkennung gibt es in Österreich genügend Beispiele. Die Messe Wien etwa erfasst jährlich rund 750.000 Gesichter und die österreichische Polizei arbeitet mit Gesichtserkennungssoftwares, um Demonstrant*innen zu identifizieren.

Netflix

Die Dokumentation „Coded Bias“ ist auf Netflix zu sehen.

Mittelmäßige Dokumentation

Nach dem ironischerweise sehr viralen Erfolg der Doku „The Social Dilemma“ über die Verführungskraft von sozialen Netzwerken, ist „Coded Bias“ nun die nächste Dokumentation im netflixschen Angebot, die sich mit zukunftsgestaltenden Technologien auseinandersetzt. „Coded Bias“ setzt aber wesentlich weniger auf die brachiachle Schocktherapie wie es etwa „The Social Dilemma“ getan hat. „Coded Bias“ versucht einzuordnen und, erzähltechnisch nicht immer spannend, zu erklären.

Für Menschen, die bereits sehr intensiv in das Thema Künstliche Intelligenz eingearbeitet sind, bietet die Dokumentation wahrscheinlich wenig Neues. Für Einsteiger*innen in dieses Thema gibt sie aber immerhin einen guten Überblick, setzt dabei gleichzeitig auch sehr viel auf Wiederholung. Als Mahnmal für die Auswirkungen, die in der Zukunft noch auf uns zukommen können, dient sie aber allemal.

Erfreulich ist, dass es, im Gegensatz zu dem sonst sehr männlichen Feld der Computerwissenschaft, fast ausschließlich Frauen sind, die in der Dokumentation zu Wort kommen.

Publiziert am 13.04.2021